Měním způsob, jak používám AI: Všechny AI modely z jednoho rozhraní (bez paušálu)

- David Ciran

- 22. 7. 2025

- Minut čtení: 4

Aktualizováno: 13. 8. 2025

Proč jsem přestal platit za ChatGPT Plus, Claude a další

Pokud se vám někdy stalo, že máte otevřených pět AI chatovacích záložek zároveň, přepínáte mezi nimi a kopírujete odpovědi jako ping-pong, nejste sami. A když k tomu připočítáte každý měsíc několik předplatných – najednou platíte desítky dolarů za funkce, které používáte jen zčásti.

Co kdyby existovalo jedno rozhraní pro všechny AI modely?

Takové, které si můžete spustit lokálně nebo pro tým? A kde si sami nastavíte rozpočty, uživatele a přístupy?

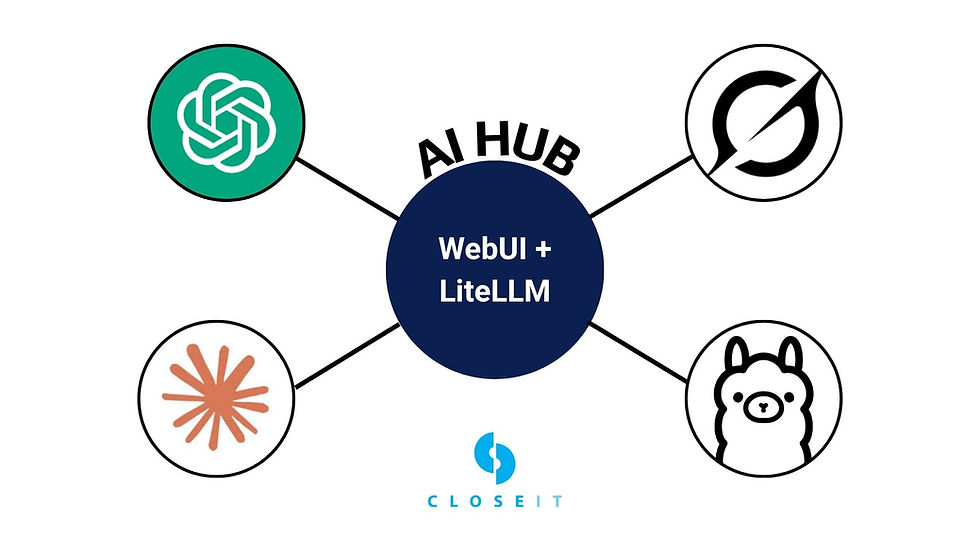

Tohle není sci-fi. Jmenuje se to Open WebUI + LiteLLM Proxy a je to možná ten nejchytřejší způsob, jak dnes přistupovat k AI.

Co je Open WebUI + LiteLLM Proxy a proč mě to nadchlo

Open WebUI je open-source rozhraní, které funguje jako ChatGPT – ale s jedním rozdílem: můžete ho připojit ke všem hlavním AI poskytovatelům (OpenAI, Anthropic, Google…) nebo i lokálním modelům jako Llama 3. Díky tomu si vytvoříte jeden centrální AI hub – přístupný přes web.

LiteLLM je mezivrstva – proxy – která překládá požadavky Open WebUI na jednotlivé API. Jednoduše řečeno: připojíte LiteLLM, přidáte API klíče od různých poskytovatelů, a máte hotovo.

Výhody, které mě přesvědčily

✅ Platíte jen za to, co skutečně použijete

Žádné paušály. Zaplatíte jen podle toho, kolik skutečně využijete. Můžete si nastavit limity pro uživatele – děti mají třeba měsíční limit $20, kolegové $50. Vy můžete mít neomezeno.

V mém případě:

Dříve: $60/měsíc za předplatná

Nyní: $15-25/měsíc podle využití

✅ Přístup ke všem modelům – z jednoho místa

Claude 3.5, GPT-4o, Gemini, Grok 4 i lokální Llama 3? Můžete je mít vedle sebe ve stejném rozhraní. Navíc uvidíte celou konverzaci na jednom místě. Ušetříte čas i mentální kapacitu.

✅ Plná kontrola nad daty

Vaše historie a konverzace zůstávají na vašem zařízení. Nejsou ukládány na servery OpenAI nebo Google. To je klíčové pro bezpečnost i soukromí.

✅ Možnost správy týmu nebo rodiny

Můžete vytvořit účty pro děti nebo kolegy, nastavit pravidla a monitorovat využití. Přidáte systémový prompt typu „nepomáhej s podváděním“, a víte, že AI nástroje budou použity správně.

Kdy to (ne)má smysl

Tahle kombinace není ideální pro všechny. Pozor na tyto případy:

❌ Kdy se vám to NEVYPLATÍ:

Jste power user jednoho modelu?

Pokud denně intensivně používáte jen GPT-4o nebo Claude a generujete dlouhé texty, můžete snadno překročit \$20-30 měsíčně. V takovém případě je klasické předplatné výhodnější.

✅ Kdy je to PERFEKTNÍ řešení:

Používáte AI jen občas?

Pro příležitostné použití

Používáte více modelů ?

Tohle je golden scenario. Například:

Claude na psaní (15-20 dotazů měsíčně)

GPT-4o na analýzu (15-20 dotazů měsíčně)

Gemini na research (15-20 dotazů měsíčně)

Lokální Llama na experimenty

Místo 3× předplatného (\$60/měsíc) zaplatíte podle skutečného využití – třeba jen \$8-25.

Chcete kontrolu a flexibilitu?

Pro týmy, vývojáře nebo rodiče, kteří chtějí mít AI pod kontrolou, je to ideální. Můžete nastavit limity, monitorovat využití a mít data na svém zařízení.

Experimentujete s různými modely?

Pokud testujete, co který model umí nejlépe, ušetříte nejen peníze, ale i čas přepínáním mezi rozhraními.

Jak si to nainstalovat během 5 minut (na MacBook)

Nainstalujte Docker: docker.com

Open WebUI:

docker run -d -p 3000:8080 -v ${HOME}/.open-webui:/app/backend/data --restart always --name open-webui ghcr.io/open-webui/open-webui:mainLiteLLM Proxy:

git clone https://github.com/BerriAI/litellm

cd litellm

docker-compose up -dPřidejte API klíče (např. z OpenAI) v LiteLLM UI (localhost:4000)

Spojte LiteLLM s Open WebUI jako proxy

Pokud chcete spustit i lokální modely, použijte nástroj jako LM Studio nebo Ollama.

Závěr: Proč bych neměnil zpět

Získal jsem přístup ke všem modelům bez paušálů. Mám data pod kontrolou. Sdílím přístup s rodinou i kolegy. A přitom platím méně – nebo aspoň férově podle využití.

Pokud vám dává smysl mít AI centralizované, bezpečné a pod vaší správou, zkuste si to sami. A pokud byste chtěli detailní návod na spuštění v cloudu pro tým – napište do komentářů. Rád připravím další díl.

❓ FAQ – Často kladené otázky

Jaký je hlavní rozdíl oproti ChatGPT?

Máte přístup ke všem modelům (ChatGPT, Claude, Gemini, lokální) z jednoho rozhraní a platíte jen za skutečné využití místo pevného předplatného.

Je to opravdu levnější než předplatná?

Záleží na způsobu využití. Pokud používáte více modelů občas, ušetříte 50-80%. Pokud jste power user jednoho modelu, klasické předplatné může být výhodnější.

Jak bezpečné jsou moje data a konverzace?

Historie konverzací zůstává lokálně na vašem zařízení. Přes API se posílají jen aktuální dotazy, ne celá konverzační historie jako u webových rozhraní.

Můžu Open WebUI sdílet s týmem nebo rodinou?

Ano, můžete vytvořit více uživatelských účtů, nastavit individuální měsíční limity a monitorovat využití. Ideální pro správu AI v týmech i rodinách.

Je technická instalace složitá?

Základní nastavení na vlastním počítači zabere 5-10 minut. Pokud umíte spustit Docker kontejner, zvládnete to bez problémů.

Které AI modely můžu připojit?

Všechny hlavní: OpenAI (GPT-4o, GPT-3.5), Anthropic (Claude 3.5), Google (Gemini), plus lokální modely jako Llama, Mistral a další přes Ollama nebo LM Studio.

Kolik to skutečně stojí v praxi?

V mém případě průměrně $18/měsíc (450 Kč) místo původních $60 (1440 Kč) za tři předplatná. Záleží na intenzitě využití.

.png)

Komentáře